Comment évaluer l’efficacité d’un traitement médical ? En 1865, le pionnier de la médecine moderne, le médecin, physiologiste et épistémologue français Claude Bernard, se posait déjà la question en ces termes : « comment savoir si c’est le remède ou la nature qui a guéri ? »

Depuis cette époque, les normes de preuve pour évaluer l’efficacité et la sécurité des traitements médicaux ont considérablement évolué. Une rupture s’est imposée dans les années 1990 avec l’avènement de la « médecine basée sur les preuves » (en anglais « evidence-based medicine »), en réponse à une régulation plus stricte des médicaments. Mais de quoi parle-t-on exactement ?

L’émergence d’une législation régulant les médicaments

Les États-Unis furent des pionniers dans le développement d’une régulation des médicaments. C’est pourquoi ils serviront de référence dans cet article.

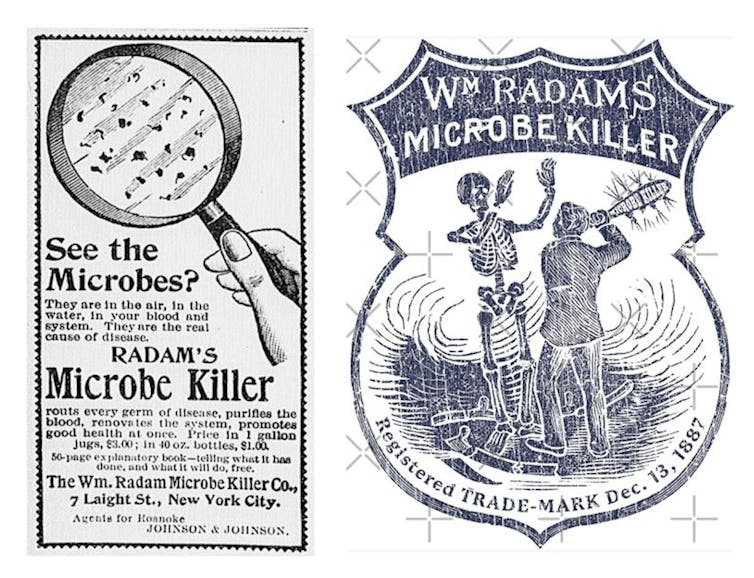

Jusqu’au début du XXe siècle, il n’existait aucun contrôle sur la production et la vente de médicaments. En 1886, on trouvait donc en vente libre des remèdes comme le « Microbe Killer » de William Radam censé guérir toutes les maladies. Afin de promouvoir son produit, Radam usa d’un marketing novateur, faisant publier des publicités dans les journaux et rédigeant plusieurs livres. Exploitant l’intérêt pour les microbes suite à la découverte de l’agent de la tuberculose par Robert Koch en 1882, il exposa dans « Microbes and the Microbe Killer » sa théorie d’une origine unique à toutes les maladies ainsi que les témoignages enthousiastes de ceux qui avaient utilisé son produit. Le Microbe Killer connut un grand succès et fut vendu dans le monde entier.

En 1902, une analyse réalisée par le Bureau of Chemistry du Département de l’Agriculture dirigé par le chimiste Harvey Washington Wiley révéla que le Microbe Killer n’était composé que d’eau, de soufre et d’acide sulfurique dilué.

Les études réalisées par l’équipe de Wiley, surnommée la « brigade des poisons », démontrèrent également la toxicité de certains conservateurs alimentaires utilisés couramment à l’époque, comme l’acide borique, les borates (sels ou esters de l’acide borique) et le formaldéhyde (formol), ainsi que la toxicité de remèdes courants, comme le Calomel et le « Mercury bichloride », deux remèdes employés contre la syphilis qui contenaient du mercure, un métal lourd aux effets particulièrement délétères sur la santé. Ces études soulignèrent l’urgence d’une loi fédérale sur les aliments et les médicaments.

Par ailleurs, en 1906, la parution du roman « The Jungle » du journaliste Upton Sinclair, qui dénonçait les pratiques insalubres de l’industrie alimentaire, suscita un lobbying du public en faveur d’une réglementation gouvernementale. C’est cette même année 1906 qui vit l’adoption par le Congrès américain, après plus de 200 rejets en 27 ans, du texte de loi « Pure Food and Drugs Act » qui interdisait enfin l’étiquetage mensonger des aliments et des médicaments. Elle entraîna la création de la « Food and Drug Administration » (FDA), dont les missions sont de s’assurer de la sécurité des aliments et des médicaments, de leur étiquetage honnête et précis, ainsi que de poursuivre la fraude.

En 1937, l’Elixir Sulfanilamide, un antibiotique sulfamidé, causa un empoisonnement de masse et la mort de plus de 100 personnes aux États-Unis. Le scandale entraîna en 1938 l’adoption de la Federal Food, Drug, and Cosmetic Act qui introduisit l’obligation faite aux fabricants de médicaments de démontrer que le médicament est sûr pour l’utilisation humaine.

Cependant, cette loi ne permettait pas encore de faire retirer du marché les nombreux médicaments intrinsèquement dangereux qui y étaient déjà présents et sa capacité à empêcher l’introduction de nouvelles préparations problématiques était limitée. En effet, la FDA ne disposait que de 60 jours pour faire la preuve de la dangerosité d’un nouveau médicament et empêcher sa commercialisation. En outre, elle ne disposait pas du pouvoir de faire respecter les bonnes pratiques de fabrication.

Il fallut que survienne une nouvelle tragédie, celle de la thalidomide, pour que la législation soit renforcée. Vendu dans les années 1950 comme sédatif et anti-nauséeux destiné aux femmes enceintes, ce médicament fut associé à de graves malformations congénitales chez des milliers de nouveau-nés en Europe. Ce drame poussa le Congrès américain a adopté en 1962 l’amendement Kefauver-Harris.

Celui-ci exigeait que tout médicament soit évalué avant sa mise sur le marché et fasse la preuve de son efficacité et de sa sécurité au moyen d’études cliniques rigoureuses.

En Europe, avant la création de l’Union européenne (UE), chaque pays disposait de sa propre législation. La Directive 65/65/CEE du 26 janvier 1965 introduisit des exigences uniformes pour l’enregistrement des médicaments. Mais ce n’est qu’en 1995 que fut créée l’Agence européenne du Médicament (EMA), dont la mission principale est d’autoriser et de contrôler les médicaments dans l’UE.

La médecine basée sur les preuves

En 1972, Archibald Leman Cochrane publia un important rapport critique sur les pratiques médicales. Il y démontrait les faiblesses des décisions médicales basées sur l’expérience personnelle du médecin, toujours limitée et subjective, et recommandait de réaliser des essais cliniques contrôlés afin d’évaluer plus objectivement chaque traitement.

Dans un essai contrôlé, l’effet d’un médicament est comparé à celui d’un placebo, une substance « inerte » qui ressemble au médicament, mais ne contient aucun ingrédient actif. Un médicament n’est estimé efficace que si ses effets positifs pour le patient sont significativement supérieurs à ceux du placebo.

De nombreux raffinements émergèrent pour augmenter la fiabilité des essais. Dans les essais « randomisés et en double insu » (ou « double aveugle », traduction de l’anglais « double-blind »), les participants recevant le placebo ou le médicament sont choisis de manière aléatoire, et ni eux ni les chercheurs ne savent quel traitement est administré.

Cette pratique réduit le risque que les attentes des participants ou les préjugés des chercheurs n’influencent les résultats de l’étude, en raison respectivement de l’effet placebo et du biais de confirmation (tendance à accorder davantage de poids aux informations qui confirment nos croyances qu’à celles qui les infirment).

En conséquence, en 1980, la FDA exigea que la preuve de l’efficacité d’un médicament soit obtenue à partir d’essais randomisés en double aveugle contre placebo. Ceux-ci devinrent le « gold standard » (standard le plus élevé) de l’évaluation des traitements médicaux.

Il fallut cependant attendre les années 1990, avec la démocratisation des ordinateurs et le développement des banques de données accessibles via Internet, pour que commence à s’imposer la pratique d’une médecine basée sur les preuves. Celle-ci est définie par l’un de ses pionniers, David L. Sackett, comme « l’utilisation consciencieuse, explicite et judicieuse des meilleures preuves actuelles dans la prise de décisions concernant les soins aux patients ».

Une pyramide des preuves

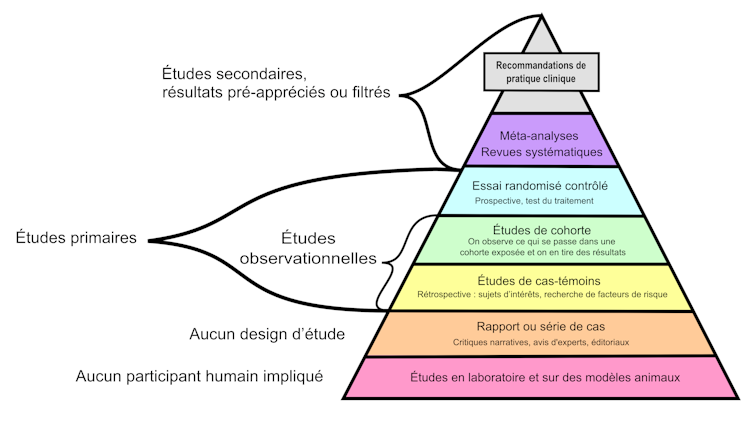

La construction du consensus médical en médecine basée sur les preuves repose sur deux grands principes : l’analyse de la totalité des études disponibles dans les banques de données et la hiérarchisation de celles-ci.

Cette hiérarchisation est souvent présentée sous la forme d’une pyramide des preuves où les études de suivi de cohortes de plusieurs milliers d’individus au cours du temps et les essais cliniques contrôlés et randomisés ont plus de valeur que les avis d’experts et les simples analyses de cas cliniques.

Les méta-analyses, des analyses statistiques qui combinent les résultats de plusieurs essais cliniques, complètent le tableau. Elles sont considérées comme la source de preuves la plus fiable.

L’ONG Cochrane

La nécessité d’organiser l’ensemble des informations concernant la recherche médicale et de les communiquer aux médecins à mener à l’émergence de l’organisation Cochrane. Organisation non gouvernementale (ONG) à but non lucratif, elle regroupe plusieurs dizaines de milliers de volontaires dans plus de 130 pays et dispose d’un siège à l’Organisation mondiale de la santé.

Cochrane évalue les essais cliniques et les méta-analyses disponibles afin de produire des guides de pratique clinique qu’elle communique ensuite aux médecins. Ses travaux sont publiés dans la bibliothèque Cochrane et sont régulièrement actualisés.

Le consensus médical actuel est encore appelé à beaucoup évoluer. En effet, si l’on se réfère aux normes de la médecine basée sur les preuves modernes, la plupart des interventions médicales (94 %) ne sont pas étayées par des preuves de haute qualité.

Un changement de paradigme encore mal accepté

Les principes de la médecine basée sur les preuves ont fait de la médecine une science. Ils ont rompu avec la « médecine d’art » pratiquée depuis l’Antiquité, qui se caractérisait par le fait que le choix du traitement était en grande partie basé sur l’expérience personnelle et l’intuition du médecin.

Toutefois, ce changement n’est pas encore unanimement accepté. Ainsi, durant la pandémie de SARS-CoV-2, on a pu assister à de violentes controverses médiatiques concernant l’hydroxychloroquine et les vaccins contre le Covid-19. La médecine basée sur les preuves a été accusée par certains d’être au service de l’industrie pharmaceutique et contraire à l’éthique médicale (cette thèse fut notamment défendue par le microbiologiste Didier Raoult et le sociologue Laurent Mucchielli).

Cependant, comme nous l’avons vu, le développement de la médecine basée sur les preuves n’est pas la conséquence des pressions de l’industrie. Au contraire, ses lobbyistes se sont souvent opposés à la mise en place d’une législation contraignante sur les médicaments, car la réalisation des essais cliniques retarde leur mise sur le marché et représente un coût très important.

Rappelons que le coût moyen pour valider un traitement est estimé à 33 millions de dollars, et que plus de 90 % des traitements médicaux candidats échouent à traverser la « vallée de la mort » des essais cliniques, dont l’objectif est de démontrer leur innocuité et leur efficacité.

Certes, la médecine basée sur les preuves n’est pas parfaite : elle reste faillible, et suscite toujours des critiques, notamment en raison des risques de conflits d’intérêts dus au financement des essais cliniques par l’industrie.

Pour améliorer sa fiabilité, diverses pistes ont été proposées, par exemple valoriser la publication des résultats négatifs dans les journaux scientifiques, ou renforcer l’indépendance des universités et des chercheurs via un meilleur financement. En attendant, dans sa forme actuelle, elle est ce dont nous disposons de plus efficace pour évaluer l’efficacité d’un traitement médical, lutter contre le charlatanisme et réduire le risque de catastrophes sanitaires.

Eric Muraille, Biologiste, Immunologiste. Directeur de recherches au FNRS, Université Libre de Bruxelles (ULB) et Elie Cogan, Professeur émérite de médecine interne, membre de l’Académie royale de Médecine de Belgique, Université Libre de Bruxelles (ULB)

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

![]()